NVIDIA HGX: Die ultimative Referenzplattform für KI und HPC

Die Welt der künstlichen Intelligenz (KI) wird von großen Sprachmodellen (LLMs) und generativer KI revolutioniert. Diese fortschrittlichen Anwendungen erfordern eine schier unvorstellbare Rechenleistung.

Genau für diese Herausforderung wurde die NVIDIA HGX Plattform entwickelt. NVIDIA HGX ist eine standardisierte Serverplattform für KI-Supercomputing im Rechenzentrum. Sie kombiniert Hochleistungs-GPUs mit NVLink- und NVSwitch-Technologie und dient als Referenzarchitektur für skalierbare KI- und HPC-Workloads.

Als Ihr langjähriger Partner für maßgeschneiderte Server- und High-Performance Computing (HPC)-Lösungen übersetzen wir die Komplexität dieser Technologie in einen direkten Wettbewerbsvorteil. Wir zeigen Ihnen, wie Sie die enorme Leistung von HGX optimal für Ihre Ziele einsetzen.

Machen Sie den nächsten Schritt in Ihre KI-Zukunft. Sprechen Sie noch heute mit unseren KI- und HPC-Spezialisten, um Ihre individuelle NVIDIA HGX-Lösung zu konfigurieren.

Hier finden Sie unsere NVIDIA HGX Server

Brauchen Sie Hilfe?

Dann rufen Sie uns einfach an oder nutzen unser Anfrageformular.

Was ist NVIDIA HGX? Mehr als nur die Summe seiner Teile

Die NVIDIA HGX Plattform ist die technologische Antwort auf eine zentrale Herausforderung in modernen Multi-GPU-Systemen: die Bandbreitenlimitierung des PCIe-Bus.

In herkömmlichen Serverarchitekturen dient der PCIe-Bus (Peripheral Component Interconnect Express) als primäre Schnittstelle für Hochleistungskomponenten. Bei rechenintensiven KI- und HPC-Anwendungen, die auf die parallele Verarbeitung durch mehrere GPUs angewiesen sind, wird die geteilte Bandbreite dieses Busses jedoch zum limitierenden Faktor. Umfangreiche Datenübertragungen zwischen den GPUs (Peer-to-Peer-Kommunikation) führen zu hoher Latenz und Sättigung des Busses. Dies hat zur Folge, dass die leistungsfähigen Recheneinheiten der GPUs nicht voll ausgelastet werden können, da sie auf Daten warten müssen – die Gesamteffizienz des Systems sinkt.

Genau an diesem Punkt setzt die NVIDIA HGX Plattform an. Sie ist kein fertiges Produkt, sondern die standardisierte Referenzarchitektur, die als Fundament für die leistungsstärksten NVIDIA GPU Server für KI und HPC dient.

Technisch ausgedrückt, ist NVIDIA HGX eine hochintegrierte Server-Plattform (ein sogenanntes Baseboard oder Referenzdesign), die mehrere NVIDIA Tensor Core GPUs (typischerweise 4 oder 8) über extrem schnelle Verbindungen miteinander vernetzt.

Das Ziel dieser Architektur ist es, den GPUs zu ermöglichen, als eine einzige, massive Super-GPU zu agieren. Dies maximiert den Datenaustausch und beschleunigt das Training komplexester KI-Modelle sowie anspruchsvolle HPC-Simulationen.

HGX auf den Punkt gebracht:

- Problem: Der PCIe-Bus bremst die Kommunikation zwischen mehreren GPUs aus.

- Lösung: HGX schafft eine direkte, ultraschnelle Verbindung zwischen allen GPUs, sodass sie als eine Einheit arbeiten.

- Ergebnis: Maximale Gesamtleistung für KI und HPC.

Die Schlüsseltechnologien für maximale NVIDIA HGX Leistung

Die überragende Leistung eines HGX-Systems beruht auf dem perfekten Zusammenspiel von drei Schlüsseltechnologien, die von NVIDIA entwickelt wurden, um Kommunikationsengpässe zu eliminieren.

- NVIDIA Tensor Core GPUs (z. B. H100, H200): Die NVIDIA H100 Tensor Core GPU, basierend auf der Hopper-Architektur, ist der aktuelle Standard für KI-Training. Die neuere NVIDIA H200 Tensor Core GPU bietet eine nochmals massiv vergrößerte und schnellere Speicherkapazität, was sie ideal für die größten LLMs und HPC-Datensätze macht.

- NVIDIA NVLink™: Hierbei handelt es sich um einen proprietären Hochgeschwindigkeits-Interconnect, der eine direkte Punkt-zu-Punkt-Verbindung zwischen den GPUs etabliert. Im Gegensatz zum PCIe-Bus, dessen geteilte Bandbreite bei parallelen Workloads einen Engpass darstellt, bietet NVLink eine exklusive und wesentlich höhere Datenübertragungsrate. Diese dedizierte Verbindung ist entscheidend, um die Latenz zu minimieren und den Datenaustausch für die GPU-zu-GPU-Kommunikation zu maximieren.

- NVIDIA NVSwitch™: Der NVSwitch agiert als intelligenter Hochgeschwindigkeitsverteiler für den NVLink-Verkehr. Er sorgt dafür, dass jede GPU mit jeder anderen GPU auf der Plattform gleichzeitig mit voller Bandbreite kommunizieren kann (All-to-All-Kommunikation). Bei einer NVIDIA HGX H100 8-GPU Plattform ermöglicht dies eine aggregierte Bandbreite von bis zu 3,6 TB/s – ein Vielfaches dessen, was über PCIe möglich wäre.

Dieses Trio verwandelt eine Ansammlung einzelner GPUs in einen kohärenten, hocheffizienten Supercomputer, der bereit für die anspruchsvollsten Aufgaben ist.

Der entscheidende Unterschied: NVIDIA HGX vs. DGX

Eine der häufigsten Fragen, die uns im Beratungsgespräch gestellt wird, betrifft den Unterschied zwischen HGX und DGX. Die Unterscheidung ist für Ihre Kaufentscheidung von zentraler Bedeutung.

- NVIDIA HGX ist die standardisierte Referenzarchitektur. Als Systemintegrator nutzen wir bei HAPPYWARE diese Architektur als Basis, um aus Komponenten führender Hersteller wie Supermicro, Gigabyte, Dell und weiterer Ihr maßgeschneidertes, NVIDIA-zertifiziertes System zu bauen. HGX bietet Ihnen dadurch maximale Flexibilität bei der Konfiguration von CPU (z. B. auch AMD EPYC), Arbeitsspeicher, Storage und Netzwerkkomponenten..

- NVIDIA DGX ist das fertige Produkt von NVIDIA. Es ist ein schlüsselfertiges, vollständig integriertes Hardware- und Softwaresystem, das direkt von NVIDIA stammt. Ein DGX-System basiert auf der HGX-Plattform, ist aber eine geschlossene, von NVIDIA optimierte „Appliance“ mit einem vollständig beschleunigten Softwarestack (NVIDIA AI Enterprise) und direktem NVIDIA-Support.

| Merkmal | NVIDIA HGX Server von HAPPYWARE | NVIDIA DGX System |

|---|---|---|

| Konzept | Flexible Plattform / Referenzdesign | Schlüsselfertiges Komplettsystem |

| Flexibilität | Hoch: CPU, RAM, Storage, Netzwerk frei wählbar | Gering: Feste, von NVIDIA optimierte Konfiguration |

| Anpassung | Maßgeschneidert für spezifische Workloads und Budgets | Standardisiert für maximale Out-of-the-Box-Leistung |

| Hersteller | Verschiedene OEMs (Supermicro, Gigabyte, etc.) | Ausschließlich NVIDIA |

| Support | Über den Systemintegrator (z. B. HAPPYWARE) und OEM | Direkt über NVIDIA Enterprise Support |

NVIDIA DGX-Alternativen: Maßgeschneiderte Leistung für Ihr Budget

Neben den schlüsselfertigen NVIDIA DGX-Systemen bieten wir bei HAPPYWARE ein breites Portfolio alternativer KI-Serverlösungen an, die auf unterschiedliche Budgets und Leistungsanforderungen zugeschnitten sind. Diese alternativen Lösungen bieten eine ähnliche Leistung wie NVIDIA DGX-Systeme, oft zu 30–50 % geringeren Kosten, und ermöglichen es, die anspruchsvollen Budgetanforderungen von KI-Projekten zu erfüllen.

Mit maßgeschneiderten Konfigurations- und Supportleistungen für jede Marke unterstützen wir Sie bei der Auswahl der exakt passenden KI-Serverlösung für Ihren Anwendungsfall.

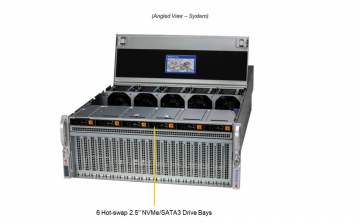

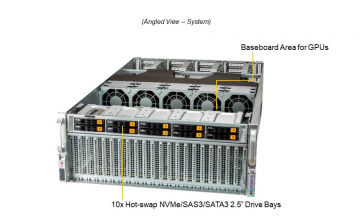

- Supermicro KI-Server: Modelle wie der Supermicro SYS-420GP-TNAR und der SYS-740GP-TNRT unterstützen bis zu acht NVIDIA H100 oder A100 HGX GPUs und stellen eine leistungsstarke Alternative zum DGX A100 dar. Diese Systeme bieten ein hervorragendes Preis-Leistungs-Verhältnis, insbesondere für große KI-Trainingsprojekte.

- Gigabyte KI-Server: Modelle wie der G292-Z40, der G482-Z50 und der G292-Z20 bieten hochperformante Lösungen für mittlere bis große KI-Projekte und unterstützen je nach Konfiguration 4–10 GPUs. Gigabyte-Systeme eignen sich aufgrund ihrer Flexibilität besonders für Forschungseinrichtungen und Universitäten.

- Dell KI-Server: Modelle wie der PowerEdge XE8545, der PowerEdge R750xa und der PowerEdge C6525 sind auf KI-Projekte der Einstiegs- und Mittelklasse ausgerichtet und unterstützen zwei bis vier GPUs. Dell-Systeme gelten als äußerst zuverlässige KI-Server-Alternativen, insbesondere in etablierten Unternehmensumgebungen.

Die Evolution der Leistung: Von A100 über H100/H200 zu Blackwell

Die HGX-Plattform entwickelt sich mit jeder GPU-Generation weiter, um die exponentiell wachsenden Anforderungen der KI zu erfüllen.

- HGX A100: Der etablierte Goldstandard der Ampere-Generation, der unzählige KI-Durchbrüche ermöglicht hat.

- HGX H100: Ein Quantensprung mit der Hopper-Architektur. Bietet die "Transformer Engine" für drastisch schnelleres Training für große Sprachmodelle und FP8-Präzision für eine unübertroffene Leistung und Effizienz.

- HGX H200: Eine Variante der H100, deren Fokus auf maximaler Speicher-Kapazität liegt. Mit bis zu 141 GB HBM3e-Speicher pro GPU beschleunigt sie Inferenz-Aufgaben für riesige Modelle massiv.

- Ausblick: HGX B200 und B300 / NVIDIA Blackwell: Die nächste Generation, NVIDIA Blackwell, verspricht mit dem HGX B200 eine nochmals gesteigerte Leistung, höhere Dichte und eine neue Generation von NVLink, um die Skalierung für KI-Fabriken und Exascale-Computing weiter voranzutreiben.

Bei HAPPYWARE stellen wir sicher, dass Sie stets Zugriff auf die neuesten NVIDIA Technologien haben, um zukunftssichere Investitionen zu tätigen.

Anwendungsfälle und Vorteile: Für wen lohnt sich die Investition in NVIDIA HGX Server?

Die Anschaffung eines HGX-basierten Systems ist eine strategische Entscheidung für Unternehmen und Forschungseinrichtungen, die an der vordersten Front der technologischen Entwicklung agieren.

Top-Vorteile auf einen Blick:

- Maximale Performance: Beseitigen Sie GPU-Kommunikationsengpässe und verkürzen Sie Trainingszeiten von Monaten auf Tage.

- Lineare Skalierbarkeit: Beginnen Sie mit einem 8-GPU-System und skalieren Sie durch die Kombination mehrerer Systeme über ultraschnelles Networking (z. B. NVIDIA Quantum Infiniband) zu massiven Clustern.

- Höhere Effizienz: Ein einzelnes, optimiertes HGX-System kann die Arbeit vieler kleinerer Server erledigen und senkt so die Gesamtbetriebskosten (TCO) in Bezug auf Platz, Strom und Verwaltung im Rechenzentrum.

- Zukunftssicherheit: Sie investieren in einen bewährten Industriestandard, der von einem riesigen Software-Ökosystem (z. B. NVIDIA AI Enterprise, NVIDIA NGC) unterstützt wird.

Typische Anwender und Workloads:

- Anspruchsvollste KI-Workloads: Training, Fine-Tuning und Inferenz von LLMs, Bild- und Videomodellen (Generative KI).

- High-Performance Computing (HPC): Komplexe Simulationen in der Wissenschaft, Molekulardynamik, Wettervorhersage und im Finanzwesen.

- Forschung & Entwicklung: Forscher und Wissenschaftler in Universitäten und privaten Laboren, die den vollen Zugriff auf dedizierte Rechenressourcen für ihre Datensätze benötigen.

- Industrie 4.0 & Automotive: Entwicklung von autonomen Fahrsystemen, digitale Zwillinge und komplexe Optimierungsmodelle.

Unsere Expertenempfehlung für NVIDIA HGX Cluster:

- Ein einzelner NVIDIA HGX-Server fungiert dank NVLink™ und NVSwitch™ als logische „Super-GPU“ und bietet aggregierte GPU-Speicherkapazität sowie massiv erhöhte Interconnect-Bandbreite. Für Exascale-AI/ML/DL-Workloads – wie Large Language Models (LLMs) mit Hunderten von Milliarden Parametern – reicht jedoch ein einzelner Knoten nicht aus.

- In diesen Fällen werden mehrere HGX-Cluster-Knoten in Rack- oder Multi-Rack-Architekturen bereitgestellt. Wenn diese über ultraschnelle Fabrics wie NVIDIA Quantum-2 InfiniBand oder Spectrum-X800 RoCE Ethernet (beide 800 Gb/s) miteinander verbunden sind, liefern sie linear skalierbare GPU-Cluster, die extreme verteilte Parallelität bei minimaler Latenz ermöglichen. Diese HGX-Cluster-Architektur bildet somit die Grundlage für eine zukunftssichere, skalierbare Supercomputing-Infrastruktur für AI und HPC.

- Für optimale Effizienz, Kühlung und Kosteneinsparungen empfehlen wir den Einsatz von NVIDIA HGX-Clustern in Liquid Cooling Data Centern oder mit Direct Liquid Cooling (DLC). Dies ist besonders kritisch für hochdichte Systeme mit NVIDIA H100 sowie für die nächste Generation von H200-, B200- und B300-GPU-Servern, bei denen ein effizientes Thermomanagement und hohe Energieeffizienz direkt in dauerhafte Leistung und niedrigere Total Costof Ownership (TCO) übersetzt werden.

Praxis-Check: Was Sie vor der Bereitstellung eines Servers mit NVIDIA HGX beachten müssen

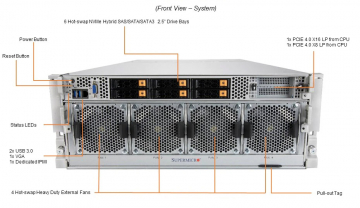

Ein System, das die volle Leistung von NVIDIA acht NVIDIA H100 GPUs bündelt, stellt hohe Anforderungen an die Infrastruktur Ihres Rechenzentrums. Unsere Experten bei HAPPYWARE beraten Sie umfassend zu diesen kritischen Punkten:

- Stromversorgung (Power): Ein voll ausgestattetes HGX H100 8-GPU-System kann eine Leistungsaufnahme von 10 kW und mehr haben. Dies erfordert eine sorgfältige Planung der Stromverteilung (PDUs) und der Absicherung im Rack.

- Kühlung (Cooling): Die extreme Leistungsdichte erzeugt eine enorme Abwärme. Während leistungsstarke luftgekühlte Lösungen existieren, wird Direct Liquid Cooling (DLC) oder Flüssigkeitskühlung für HGX-Systeme zunehmend zum Standard, um die Systeme möglichst effizient zu kühlen und so maximale Performance bei höherer Dichte im Rechenzentrum zu gewährleisten.

- Platz und Gewicht: HGX-Server sind in der Regel große (oft 4U oder mehr) und schwere Systeme, was bei der Rack-Planung berücksichtigt werden muss.

Ihre individuelle NVIDIA HGX Lösung – konfiguriert von HAPPYWARE

Die NVIDIA HGX Plattform bietet die technologische Grundlage. Wir bei HAPPYWARE verwandeln diese Grundlage in eine maßgeschneiderte, produktionsbereite und zuverlässige Lösung, die exakt auf Ihre Anforderungen zugeschnitten ist.

Seit 1999 unterstützen wir Unternehmen in ganz Europa mit individuell konfigurierten Server- und Storage-Systemen. Profitieren Sie von unserer ISO 9001-zertifizierten Qualität und unserem tiefen technischen Know-how.

Unser Service für Sie:

- Expertenberatung: Wir analysieren Ihren Workload und empfehlen die optimale Konfiguration – von der CPU über den Speicher bis zum Netzwerk.

- Individuelle Fertigung: Jeder GPU-Server mit NVIDIA HGX wird in unserem Haus nach Ihren Wünschen gebaut und strengen Tests unterzogen.

- Infrastruktur-Planung: Wir unterstützen Sie bei der Planung der notwendigen Strom- und Kühlkapazitäten.

- Umfassender Support: Mit europaweitem Vor-Ort-Service und bis zu 6 Jahren Garantieverlängerung sichern wir Ihre Investition langfristig ab.

Machen Sie den nächsten Schritt in Ihre KI-Zukunft. Sprechen Sie noch heute mit unseren HPC- und KI-Spezialisten, um Ihre individuelle NVIDIA HGX-Lösung zu konfigurieren.

Häufig gestellte Fragen (FAQ) zu NVIDIA HGX

Was ist der Hauptvorteil von NVLink und NVSwitch im Vergleich zu PCIe?

Der Hauptvorteil ist die Bandbreite und die direkte Kommunikation. NVLink bietet eine dedizierte, extrem schnelle Verbindung zwischen den GPUs. NVSwitch ermöglicht, dass alle GPUs gleichzeitig miteinander kommunizieren können, was den "Kommunikationsstau" vermeidet, der bei einer gemeinsamen Nutzung von PCIe-Lanes entsteht. Das Ergebnis ist eine beschleunigte Anwendungsleistung.

Bietet HAPPYWARE auch HGX-Systeme mit den neuen NVIDIA H200 GPUs an?

Ja. Wir arbeiten eng mit unseren Partnern zusammen, um Ihnen stets die fortschrittlichsten Technologien anbieten zu können. Systeme, die auf der NVIDIA HGX H200 Plattform basieren, sind ideal für Kunden mit Workloads, die eine maximale Speicher-Kapazität und -Bandbreite pro GPU erfordern. Kontaktieren Sie unser Vertriebsteam für aktuelle Verfügbarkeiten und Konfigurationen.

Kann ich ein HGX-System mit AMD EPYC™ CPUs bekommen?

Ja, das ist einer der großen Vorteile der flexiblen HGX-Plattform. Wir können Ihr System sowohl mit den neuesten Intel® Xeon® Prozessoren als auch mit leistungsstarken AMD EPYC™ CPUs konfigurieren, je nachdem, welche Architektur für Ihren spezifischen Anwendungsfall am besten geeignet ist.

Ist ein HGX-System für Deep Learning besser als ein Standard-GPU-Server?

Für das Training großer Deep Learning-Modelle, insbesondere im Bereich große Sprachmodelle, ist ein HGX-System signifikant überlegen. Die hohe Interconnect-Bandbreite ist entscheidend, wenn das Modell und die Datensätze auf mehrere GPUs verteilt werden müssen, was bei fast allen modernen, komplexen Modellen der Fall ist.