Cluster Computing – Mehr Leistung durch hochwertige Lösungen

Wer Verfügbarkeit oder Rechenkapazität erhöhen will, ist mit Cluster Computing gut beraten. HAPPYWARE informiert darüber, was hinter der Technik steckt und welche Möglichkeiten sich für Sie mit unseren Cluster Computing Lösungen bieten.

HPC Cluster

HPC Cluster, High Performance Computing Cluster (HPC Cluster) als schlüsselfertige Lösung kaufen!

HPC Cluster richtig beraten und Cluster Preis niedrig halten z.B. für Finanzsimulationen.

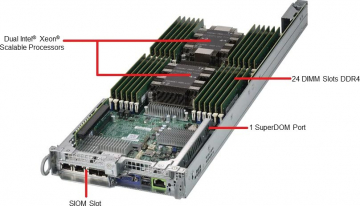

Cluster Server, Cluster Nodes

Supermicro Cluster Server: Hier jeden Knoten optimal konfigurieren und kaufen!

Hier finden Sie Ihr Cluster Node, Cluster PCs und Mini-Cluster z.B. als Cluster Dateiserver mit zwei Knoten.

Virtualisierungscluster

Cluster in a Box Lösungen: Fehlertolerant und voll redundant aufgebaut.

Virtualisierungscluster mit dem besten Preis/ Performance für maximale Ausfallsicherheit!

Hier finden Sie unsere Cluster Computing

Brauchen Sie Hilfe?

Dann rufen Sie uns einfach an oder nutzen unser Anfrageformular.

Was ist ein Computer Cluster?

Als Computer Cluster bezeichnet man in der IT, Server Systeme, die in einer losen Zusammenkopplung für spezielle Aufgaben bereitgestellt werden. Ganz allgemein besteht ein Cluster aus vier verschiedenen Teilen:

- Einer Steuereinheit, die je nach Clusterart ein eigenständiges Server System ist und oft als Frontend System bekannt ist.

- Den Knoten, die die Arbeit machen (Cluster Nodes genannt).

- Einen gemeinsamen Datenbereich auf denen alle zum Cluster gehörenden Systeme zugreifen können.

- Einem gemeinsamen Netzwerk (siehe High Performance Netzwerke)

Die einzelne Systeme werden gemeinsam verwaltet.

Wie hat sich Cluster Computing entwickelt?

Cluster Computing gibt es seit den 1980ziger Jahren. Die Firma DEC (Digital Equipment Cooperation) stellte eine Möglichkeit vor, ihre Micro-Vaxen mit einer großen VAX über Ethernet zu verbinden, um den gemeinsamen Datenspeicher zu nutzen.

Als es dann später die ersten Parallelrechner gab, stellte man fest, dass diese recht teuer waren, weil diese IT Systeme ganz spezielle Hardware und Software benötigten, die nur von wenigen Kunden eingesetzt wurden.

Auf Basis der alten Lösung von DEC stellte man normale PCs, die unter dem Betriebssystem Linux laufen, zu einem Cluster zusammen. Eine der ersten Lösungen im Cluster Computing war das Beowulf Cluster.

Was müssen Computer Cluster Lösungen heute leisten?

Durch immer leistungsfähigere Systeme und Netzwerke sind die heutigen Cluster zu einem essenziellen Bestandteil einer modernen IT Landschaft geworden. Kein einzelnes IT System kann die komplexen Berechnungsaufgaben alleine in einer annehmbaren Zeit lösen. Heute werden immer mehr Daten an den verschiedensten Stellen erfasst und die verfügbare Datenmenge steigt jedes Jahr kontinuierlich an. Damit wird es immer wichtiger, diese Daten in kürzester Zeit zuverlässig zu verarbeiten. IT Systeme, die für die Berechnung solcher Datenmengen ausgelegt sind, fallen unter den Begriff ,,High Performance Computing‘‘. Diese Cluster Computing Systeme bestehen aus speziellen Hochleistungsrechnern und GPU Systemen. Der gemeinsame Datenbereich kann ein einzelner NFS-Server oder aber eine High Performance Storage Lösung sein.

Welche Arten von Computer Cluster gibt es?

Je nach Anforderung an das Cluster lassen sich diese in verschieden Kategorien einteilen:

- High Performance Computing – Cluster Computing für hohe AnsprücheDiese Clusterart findet man in technisch-wissenschaftlichen Bereichen, so z.B. bei Universitäten, Forschungseinrichtungen und Forschungsabteilungen von Firmen. Die Zeit, die für eine Rechnung benötigt wird, soll möglichst kurz sein, da viele Informationen zwischen den einzelnen IT-Systemen transportiert werden. Deshalb ist hier ein Netzwerk gefordert, das mit einer kurzen Latenzzeit und schnellen Übertragungszeiten überzeugt. Für mehr Informationen zu dieser Cluster Computing Variante sehen Sie in unserem Artikel zum Thema High Performance Netzwerke.

- Big Data – Cluster Computing zur Verarbeitung großer DatenpaketeWenn aus einer riesigen Menge von heterogenen Daten nach speziellen Vorgaben Analysen erstellt werden sollen, ist diese Art von Cluster Computing ideal. Die einzelnen Knoten haben dabei in aller Regel sehr viel eigenen Datenspeicher. Aus der riesigen Menge von heterogenen Daten wird jedem Knoten ein Teil zugewiesen. Der Transport der Daten erfolgt über das Netzwerk in aller Regel nur zu Anfang und zum Ende. Damit ist bei diesen Clustern eine kurze Latenzzeit des Netzwerkes nicht notwendig. Allerdings sind die zu transportierenden Datenpakete sehr groß. Oft werden diese Art von Cluster Computing im Marketingbereich eingesetzt um z.B. das Käuferverhalten zu analysieren.

- High Performance Data Analytics – Cluster Computing für große Datenmengen in kurzer Zeit Genauso wie bei BIG Data Cluster Computing liegen hier sehr große Datenmengen zur Verarbeitung vor. Der Unterschied ist, dass die Berechnung hier innerhalb von Sekundenbruchteilen erfolgen muss. Die Knoten eines High Performance Data Analytics Clusters profitieren von GPU Zusatzkarten, die parallel eine schnelle Verarbeitung auf Basis von FP64 und FP32 Daten unter zu Hilfenahme von KI bzw. AI Software berechnen. Hierzu erfahren Sie mehr in unserem Beitrag zum Thema GPU Computing. Cluster Computing dieser Art ist typisch für den Hochfrequenzaktienhandel.

- Visualisierung – Cluster Computing für leistungsstarke Simulationen Die Produktentwicklung von z.B. Flugzeugen sowie die Prozessentwicklung im Bereich Chemie werden heute in aller Regel komplett in einem IT-System vorgenommen und dort vollständig simuliert. Nach der ersten Fertigung fließen in dieser Simulation auch noch Echtdaten ein (IoT). Dabei fallen riesige Datenmengen an, die als Video oder Animation dargestellt werden sollen. Cluster, die diese Anforderungen bewältigen müssen, benötigen GPU Zusatzkarten und fallen unter der Kategorie Visualisierungscluster.

- Virtualisierung Virtualisierung ist eine Anwendung, die heute überall zu finden ist. Die virtualisierten Systeme können in wenigen Sekunden von einem Knoten auf den anderen Knoten verschoben werden – eine Kernfunktion jeder hochverfügbaren Private Cloud. Die Steuereinheit ist bei diesen Clustern oft ein komplexes Steuerprogramm.

- Load Balancer Load Balancing Cluster verteilen einen einkommenden Datenstrom, wie er im Bereich Web-Server auftritt, auf ein dahinter angeordnetes Web-Server Cluster. Heute sind diese Cluster ein Bestandteil von Software Defined Networking. Die eingesetzte Hardware (Bar Metal Switch) ist ein spezielles System mit vielen Netzwerk-Anschlüssen, auf denen Cumulus Linux als Basisbetriebssystem läuft.

Zahlreiche Cluster Computing Lösungen bei HAPPYWARE

Sie haben Fragen zum Thema Cluster Computing oder möchten sich darüber informieren, welche Lösungen aus unserem Angebot für Sie am besten geeignet sind? Dann kontaktieren Sie uns gern! Wir helfen Ihnen persönlich weiter.