HPC Cluster - High Performance Computing Cluster für hohe Ansprüche

High Performance Computing Cluster Systeme, kurz HPC Cluster findet man in technisch-wissenschaftlichen Bereichen, so z.B. bei Universitäten, Forschungseinrichtungen und Forschungsabteilungen von Firmen. Die dort zu erledigenden Aufgaben, wie zum Beispiel Wetter- oder Finanzprognosen, werden häufig im HPC Cluster in kleinere Teilaufgaben zerlegt und dann auf die Cluster Nodes verteilt.

Wichtig hierbei ist dann die Cluster interne Netzwerkverbindung, da die Cluster Nodes sehr viele kleine Informationen austauschen. Diese müssen auf schnellstem Weg von einem Cluster Node zu einem anderen Cluster Node transportiert werden. Deshalb muss auf eine kurze Latenzzeit des Netzwerkes geachtet werden. Weiterhin ist wichtig, dass die benötigten und erzeugten Daten von allen Cluster Nodes eines HPC Clusters zur gleichen Zeit gelesen oder geschrieben werden können.

Hochleistungsrechner

Hochleistungsrechner für HPC, z.B. für Parallel Computing mit vielen Cores pro CPU konfigurieren und kaufen!

High Performance Server oder HPC Workstations für individuelle Einsatzzwecke für Ihr eigenes Cluster.

High Performance Storage

High Performance Storage kaufen für Ihre besonders wichtigen Daten z.B. als All-NVMe File Storage.

Storage für stabile und skalierbare Filesysteme z.B. LustreFS, GlusterFS oder GFS Red Hat.

High Performance Network

Wir bieten High Performance Network auf Basis von: InfiniBand, Omnipath und 100GBit Ethernet.

Hochleistungsnetzwerke (HPN) Hardware online kaufen.

Cluster Computing

Server Cluster für Cluster Computing kaufen bestehend aus Cluster Hardware und Cluster Hardware.

Cluster Management für Ihr Server Cluster oder Storage Cluster mit passender Cluster Software.

GPU Computing

Hoch performante GPU Computing Lösungen

Hier finden Sie GPU Server, GPU Workstations und GPU Cluster mit NVIDIA GPUs

Künstliche Intelligenz

Unsere Server für Künstliche Intelligenz liefern höchste Leistung für komplexe Anwendungen und effiziente Datenverarbeitung.

Setzen Sie auf Zukunftstechnologie – jetzt Ihren KI-Server individuell konfigurieren oder sich beraten lassen!

Hier finden Sie unsere HPC - High Performance Computing

Brauchen Sie Hilfe?

Dann rufen Sie uns einfach an oder nutzen unser Anfrageformular.

Aufbau eines High Performance Computing Cluster Systems

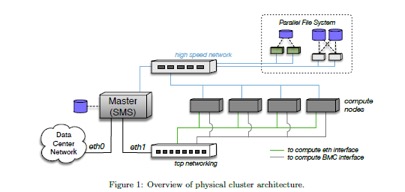

- Der Cluster Server (Master oder Frontend genannt) verwaltet den Zugriff und stellt Programme und den Home-Datenbereich zur Verfügung.

- Die Cluster Nodes erledigen die Berechnung.

- Ein TCP-Netzwerk wird für den Informationsaustausch im HPC Clusters verwendet.

- Ein High Performance Network ist erforderlich, um die Datenübertragung mit sehr geringer Latenz zu ermöglichen.

- Der High Performance Storage (Parallel File System) ermöglicht den gleichzeitigen Schreib-Zugriff aller Cluster Nodes.

- Das BMC Interface (IPMI Interface) ist der Zugang für den Administrator zur Verwaltung der Hardware.

Alle Cluster Nodes eines HPC Clusters werden immer mit dem gleichen Prozessortyps des jeweiligen gewählten Herstellers ausgestattet. Verschiedene Hersteller und Typen werden in aller Regel nicht in einem HPC Cluster gemischt. Eine unterschiedliche Ausstattung mit Hauptspeicher und anderen Ressourcen ist durchaus möglich. Dies sollte dann aber in der Konfiguration der Job Control Software berücksichtigt werden.

Wann kommen HPC Cluster zum Einsatz?

HPC Cluster sind dann besonders wirkungsvoll, wenn sie für Berechnungen angewandt werden, die sich in verschiedene Teilaufgaben untergliedern lassen. Ebenso kann ein HPC Cluster aber auch eine Reihe kleinerer Aufgaben parallel zueinander bewältigen. Ein High Performance Computing Cluster ist zudem in der Lage, eine einzelne Anwendung für mehrere Nutzer gleichzeitig zur Verfügung zu stellen, um durch das simultane Arbeiten Kosten und Zeit zu sparen.

Je nach Ihrem Budget und Anforderungen kann HAPPYWARE Ihnen einen HPC Cluster zusammenstellen. Mit verschiedenen konfigurierten Cluster Knoten, einem High Speed Network und einem parallelen File System. Für das Management des HPC Clusters setzen wir auf die bekannte Lösung von OpenHPC, um die Verwaltung des Clusters effektiv und intuitiv zu gestalten.

Wenn Sie mehr über mögliche Anwendungsszenarien für HPC Cluster erfahren möchten, dann hilft Ihnen unser HPC-Ingenieur Herr Jürgen Kabelitz gerne weiter. Er leitet die Clusterabteilung und steht Ihnen unter der Rufnummer +49 4181 23577 79 für Fragen zur Verfügung!

HPC Cluster Lösungen von HAPPYWARE

Hier haben wir für Sie einige mögliche Konfigurationen von HPC Clustern zusammengestellt:

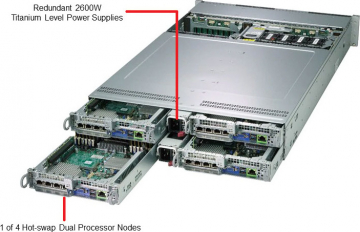

- Frontend oder Master Server 4 HE Cluster Server mit 24 3,5’’ Laufwerkschächten, SSD für das Betriebssystem, Dual Port 10 Gb/s Netzwerk Adapter, FDR Infiniband Adapter

- Cluster Knoten 12 Cluster Nodes mit dual CPU und 64 GB Arbeitsspeicher, 12 Cluster Nodes mit dual CPU und 256 GB Arbeitsspeicher, 6 GPU Computing Systeme mit je 4 Tesla V100 SXM2 und 512 GB Arbeitsspeicher NVIDIA Werte angeben, FDR Infiniband und 10 GB/s TCP Netzwerk

- High Performance Storage 1 Storage System mit 32 x NF1 SSD mit je 16 TB Kapazität, 2 Storage Systeme mit je 45 Hot-Swap Schächte, Netzwerkverbindung: 10 Gb/s TCP/IP und FDR Infiniband

- HPC Cluster Management – mit OpenHPC und xCAT Für das Management von HPC Clustern und Daten braucht es eine entsprechend leistungsfähige Software. Zu diesem Zweck bieten wir Ihnen mit OpenHPC und xCAT zwei bewährte Lösungen an.

- HPC Cluster mit OpenHPC OpenHPC ermöglicht grundlegendes HPC Cluster Management auf Linux- und OpenSource-Basis.

Leistungsumfang

- Forwarding der Systemlogs möglich

- Nagios Monitoring & Ganglia Monitoring – Opensource-Lösung für Infrastrukturen und skalierbares System Monitoring für HPC Cluster sowie Grids

- ClusterShell Event basierte Python Bibliothek für das parallele Ausführen von Befehlen auf dem Cluster

- Genders - statische Cluster Konfigurationsdatenbank

- ConMan - Serial Console Management

- NHC - Node health check

- Entwicklersoftware wie Easy_Build, hwloc, spack und valgrind

- Compiler wie GNU Compiler, LLVM Compiler

- MPI Stacks

- Job Kontrollsystem wie PBS Professionel oder Slurm

- Infiniband Support & Omni-Path Support für x86_64 Architekturen

- BeeGFS Support für das Mounten von BeeGFS Filesystemen

- Lustre Client Support für das Mounten von Lustre Filesystemen

- GEOPM Global Extensible Power Manager

- Unterstützung von INTEL Parallel Studio XE Software

- Unterstützung von lokaler Software mit der Modules Software

- Unterstützung von Nodes mit stateful oder stateless Konfiguration

Unterstützte Betriebssysteme

- CentOS7.5

- SUSE Linux Enterprise Server 12 SP3

Unterstützte Hardware Architekturen

- x86_64

- aarch64

HPC Cluster mit xCAT xCAT ist ein “Extreme Cloud Administration Toolkit” und ermöglicht ein umfassendes HPC Cluster Management.

Geeignet für folgende Anwendungen

- Clouds

- Cluster

- High-Performance -Cluster

- Grids

- Datacentre

- Renderfarms

- Online Gaming Infrastructure

- Oder jede andere System Zusammenstellung, die möglich ist.

Leistungsumfang

- Erkennen von Servern im Netz

- Ausführen von Remote System Management

- Bereitstellung von Betriebssystemen auf physikalischen oder virtuellen Servern

- Diskful (stateful) oder Diskless (stateless) Installation

- Installation und Konfiguration von Benutzersoftware

- Paralleles Systemmanagement

- Integration der Cloud

Unterstützte Betriebssysteme

- RHEL

- SLES

- Ubuntu

- Debian

- CentOS

- Fedora

- Scientific Linux

- Oracle Linux

- Windows

- Esxi

- und etliche andere

Unterstützte Hardware Architekturen

- IBM Power

- IBM Power LE

- x86_64

Unterstützte Virtualisierungs-Infrastruktur

- IBM PowerKVM

- IBM zVM

- ESXI

- XEN

Leistungswerte für mögliche Prozessoren

Als Leistungswerte wurde auf die Werte von SPEC.ORG zurückgegriffen. Dabei werden ausschließlich die Werte für SPECrate 2017 Integer und SPECrate 2017 Floating Point verglichen:

| Hersteller | Modell | Prozessor | Taktrate | # CPUs | # cores | # Threads | Base Integer | Peak Integer | Base Floatingpoint | Peak Floatingpoint |

|---|---|---|---|---|---|---|---|---|---|---|

| Giagbyte | R181-791 | AMD EPYC 7601 | 2,2 GHz | 2 | 64 | 128 | 281 | 309 | 265 | 275 |

| Supermicro | 6029U-TR4 | Xeon Silver 4110 | 2,1 GHz | 2 | 16 | 32 | 74,1 | 78,8 | 87,2 | 84,8 |

| Supermicro | 6029U-TR4 | Xeon Gold 5120 | 2.2 GHz | 2 | 28 | 56 | 146 | 137 | 143 | 140 |

| Supermicro | 6029U-TR4 | Xeon Gold 6140 | 2.3 GHz | 2 | 36 | 72 | 203 | 192 | 186 | 183 |

NVIDIA Tesla V100 SXM2 64Bit 7,8 TFlops; 32Bit 15,7 TFlops; 125 TFlops für Tensor Operationen.

HPC Cluster und mehr von HAPPYWARE – Ihr Partner für starke Cluster-Lösungen

Wir sind Ihr Spezialist für individuell konfigurierte und extrem performante Cluster – ganz gleich, ob es um GPU Cluster, HPC Cluster oder andere Setups geht. Gerne stellen wir auch für Ihr Unternehmen ein bedarfsgerechtes System zu einem fairen Preis zusammen.

Für wissenschaftliche Institutionen und Bildungsstätten bieten wir außerdem mit unserem Rabatt für Forschung und Lehre besonders günstige Konditionen. Sprechen Sie uns bei Interesse auf mögliche Rabatte an.

Möchten Sie mehr über die Ausstattung unserer HPC Cluster erfahren oder benötigen Sie eine individuell konzipierte Cluster-Lösung? Melden Sie sich unter der Nummer +49 4181 23577 79 bei unserem Cluster-Spezialisten Jürgen Kabelitz und lassen Sie sich passend zu Ihren Anforderungen beraten!